我们为什么需要剖析HashMap集合类?

- HashMap和HashTable有什么区别?

- HashMap中默认的初始化容量和加载因子是多少?如果加载因子设置的太小会出现什么问题?如果设置的太大或出现什么问题?

- HashMap中保存的元素是否可以包含null?保存的元素是否有序?

- HashMap是否是线程安全的?如果多线程操作HashMap会出现什么问题?

HashMap的主要结构

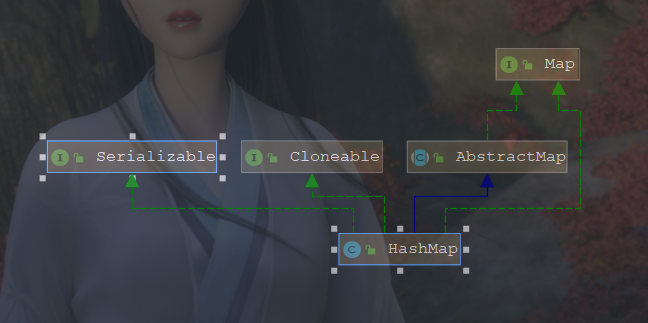

1 | public class HashMap<K,V> extends AbstractMap<K,V> implements Map<K,V>, Cloneable, Serializable |

丛上图可以看出HashMap继承了AbstractMap类、实现了Map接口、Cloneable接口以及Serializable序列化接口。

- Map :定义了集合类最基础的功能,包括size()、isEmpty()、get()、put()、containsKey()、containsValue()方法。

- AbstractMap:实现了一些比较基本的方法,但是通过查看HashMap类发现AbstractMap中的方法在HashMap都实现了重写。暂不清楚这个抽象类的作用在此。

- Cloneable:我们都知道实现Cloneable的接口都可以使用clone方法实现深复制或浅复制,但HashMap有点不一样,它可以被称为浅复制,但又不是笼统意义的浅复制,为什么这么说,等我们分析到clone方法的时候再做详细的解释。

- Serializable:不需要说,表示可序列化和反序列化。

HashMap中主要的属性和方法:

属性

默认的属性

1 | //HashMap中默认初始化的数组table大小(16). |

普通属性

1 | // HashMap是由数组+链表+红黑树组成,这个便是HashMap中数组,如果HashMap中的元素能够均匀的分布在数组table上,则这个HashMap是非常高效的. |

注意:

链表的大小不是超过默认的树化大小(8)就一定会树化,还需要满足数组table大小超过最小的数组树化大小(64),只有这两个值满足时,才会升级为红黑树,否则只是扩容数组table的大小。

加载的因子(loadFactor)的值不要轻易修改,若设置太大会造成查询速度的变慢;若设置的太小则会造成空间浪费以及多次扩容。

方法

构造方法

1 | public HashMap(int initialCapacity) { |

上边的代码就是初始化HashMap的方法,其它的都很简单,但是我不知道大家有没有发现问题?

- 传入了初始化的容量,为什么没有初始化HashMaptable的数组table大小?

- 之前说过threshold的取值(threshold=loadFactor*cap),但是这里已经传入了cap和loadFactor,为什么不直接计算呢?

当时也是一脸懵逼,但是看了之后的代码和搜索资料才明白,代码的作者是真的牛逼啊,分分钟给跪下的节奏。那么到底牛逼在什么地方,我们就先分析下tableSizeFor(initialCapacity)这个方法……

1 | static final int tableSizeFor(int cap) { |

初看这个方法觉得好头大,这到底是要干什么,一堆的右移位补0和异或操作,到底是需要实现什么? 经过查资料发现,这段代码的主要目的是获取大于输入参数(cap)且小于最接近2的n次方幂的值返回,例如输入的是10,返回的是16。感觉有点高大上啊,对于一些运算,进行位移操作,从而加快运行的速度,当然这个还不是牛逼的地方,只能算开胃菜,为后边牛逼的地方打基础,我们继续学习后边比较牛逼的代码……

普通方法

- put(K key, V value):插入元素

1 | public V put(K key, V value) { |

上述代码是插入元素的整体逻辑,包括数组的初始化、替换旧的值、添加新元素到数组/链表/红黑树、树化、扩容等。我们知道在初始化HashMap时并没有初始化数组table,那么在第一次进入插入元素时,肯定会执行resize()方法,我们看看resize()方法做了什么操作。

1 | final Node<K,V>[] resize() { |

上边的代码比较长,但是别着急,我们一步步来进行分析。

首先看第一个if (oldCap > 0)判断,如果满足该条件说明HashMap中的数组table已经进行初始化过了,此时的HashMap中元素的数量超过了threshold的值,需要对table数组的大小进行扩容。扩容分为两种情况:

- 如果旧的数组大小已经大于或等于默认最大数组的大小,则将threshold置为Integer的允许的最大值,这里主要为了将阈值调到最大,防止马上新增一个元素之后又来进行扩容。

- 若不满足上述条件,则将旧数组的大小*2赋值给新的数组。如果新数组大小小于默认的最大的数组大小并且新数组大小大于默认的数组大小,则调整阈值为新数组的大小。

从上述代码可以看到HashMap的数组扩容一般为原来大小的2倍。

第二个else if(oldThr > 0)判断,若满足该条件说明,table数组还没有初始化过以及在初始化HashMap实例时是带有参数的。这里的oldThr应该是之前所说的tableSizeFor()的值。这里做法也比较简单,就是将阈值赋值给新数组的大小。

进入else判断,新数组的大小取默认的数组大小(16),阈值则是上述所说的(loadFactor*defaultCapity).

又是if(newThr == 0): 这个判断我没有想到什么情况会出现这种问题,这个之后在查找查找资料?

之前都是进行HashMap扩容的操作,扩容操作之后我们需要将之前存在的元素重新分布到新的数组上,具体的转移逻辑如下,这也是之前所说代码真正牛逼的地方。

如果table数组下标所对应的元素为null,则跳过

如果table数组下标所对应的元素只有一个,不是链表或者红黑树,则根据hash值和新数组大小计算新的下标进行转移。

如果table数组下表所对应的元素是树节点时,暂不做分析。

不满足上述条件时,则表明该下标对应的是个链表,遍历链表上的每一个元素,然后进行转移到新数组上。在我想法中,我可以像插入元素时候一样,根据元素的hash值和新数组大小取余获得元素新下标位置进行转移,但是我发现代码不是如此,这便是HashMap代码的牛逼之处……

假设旧的数组大小为16(二进制为00010000,减1二进制为00001111),

新的数组大小为32(二进制为00100000,减1二进制为00011111),

有两个元素hash值为5(00000101)和21(00010101),在旧的数组上下标为5和5,

在新数组时元素5的下标位置为00000101和00011111逻辑与为00000101(值为5),元素21新的下标位置为00010101(值为21)。多试几个数据发现,只需要看原来的hash值新增的那个bit是1还是0就好了,(即看上述的从右往左数第5位是否为0), 是0的话该元素的数组索引就没有变,是1的话就说明该元素的索引位置是”旧的下标”+oldCap的值。

通过上述的操作,可以将下标对应的链表元素均匀的分布到新的数组中,要么在原位置,要么在旧的下标+oldCap的位置中,这样整个旧的数组遍历下来就可以均匀到分布到整个新的数组中。

最后返回新的数组。

注意:虽然本章没有分析1.7的源码,但是还是做一下对比:

1: 相对于1.7来说,1.8的HashMap不需要重新计算hash,

2: 相对于1.7来说,1.8的HashMap采用尾插法的方式,有效的避免了并发死锁的问题。

分析完了HashMap的插入元素的方法,我先做个小小的总结:

- HashMap是在第一次插入元素的时候进行的初始化,初始化的操作具体分为三种情况:

- 没有传入初始容量: 取默认的数组大小和加载因子,阈值threshold=loadFactor*initCap;

- 传入初始容量,未传加载因子:阈值取大于并最接近传入的初始容量2的n次方的值,数组大小取阈值;

- 传入初始容量以及加载因子:和上述一致

- HashMap扩容的大小一般是旧数组大小的2倍

- HashMap扩容转移元素时,采用的是尾插法的方式。

- HashMap的扩容还是比较耗时的,因此我们应该一开始就设置好我们的初始容量,例如我们需要存入1000个元素,我们可以设置new HashMap(1000)来设置,HashMap内部实际为new HashMap(1024),但是事实上这也不是最合适的大小,因为我们知道当HashMap中的元素超过1024*0.75的时候,即大约768时,就会扩容,因此我们最开始设置大小应为超过1024,设置为2048。

- get(K key):获取元素

1 | public V get(Object key) { |

上边的代码非常的简单,获取HashMap中键对应的值时,主要也是根据hash值和键值来获取。具体的逻辑如下:

- a.首先判断数组大小是否为空,若为空则返回空。

- b.根据键的hash值获取所在数组上的下标,如果该索引上元素为空,则返回空。

- c.判断该索引上的元素的hash值是否相等,若想等继续判断键的地址是否相等或两个键的值是否相等,若想等,则返回该元素Node,否则继续执行

- d.判断是否满足该数组索引上的元素是否是树节点,如果是树节点,则查找树,这个就不在此分析,可以通过前序遍历、中序遍历、后序遍历来查找。

- e.当不满足上述条件时,这说明该数组索引上的是链表结构,需要遍历链表的元素然后判断,满足之后进行返回该元素。

clone():复制方法

1 | public Object clone() { |

在开篇的时候说过HashMap的复制不能称之为严谨的深复制或者浅复制,为什么会这么说,我们先说明下深复制和浅复制的原理:深复制和浅复制都可以将一个对象的属性拷贝到另一个相同类型的对象中去,不同的是深复制会将对象中属性是对象或是数组的也重新复制一份;而浅复制只是复制了相同类型的对象,里边的属性也是引用之前原对象中属性的地址。

了解了深复制和浅复制,我们再看下上边的代码。首先通过获取通过调用Object类的clone()方法实现浅复制,然后将新对象中的table数组引用、entrySet等属性值为空,继续通过调用插入集合的方法将原有HashMap中保存的元素插入到新对象中。

为什么要这样做?我理解的是这样子做可以满足像原有的HashMap中插入新元素的时候,不会影响复制出来的对象。同理,像新对象插入元素的时候,不会影响原有对象。但是为什么说这样子还不是深复制,因为如果修改了HashMap存储元素的内容,两个对象都会发生改变,所以不是严谨的深复制和浅复制。

面试提问

- HashMap是线程安全的吗?多线程操作时会出现什么问题?

答:不是线程安全的。多线程插入元素的时候,可能会导致数据丢失。 - HashMap默认的初始数组大小是多少?默认的加载因子是多少?设置大了和设置小了会有什么问题?

答:数组默认是16,加载因子时0.75。若设置过大会造成对空间的利用更充分,但造成查询的效率较低;若设置过小的话,会造成插入一小部分元素就需要扩容,从而导致空间的浪费。 - HashMap是在什么时候初始化的?一般扩容的大小是多少?

答:在第一次插入元素的时候进行初始化。初始化会根据是否传入了初始容量而有不同的初始化逻辑。一般扩容的大小是原有的2倍。 - HashMap为什么要求我们存储的元素需要实现hash()和equals方法?

答:HashMap是通过hash值的比较来获取元素在数组上的位置,如果元素的hash值越不重复则在散列表中分散的越好,越均匀。- 如果两个元素的hash值相等, 则这两个元素不一定相等

- 如果两个元素相等,则他们的hash值一定相等

- 判断两个元素是否相等时,首先hash值是否相等,然后判断两个键是否相等,若想等则进行替换,若不相等则进行插入。

- HashMap中使用hash值主要的目的是什么?

答:加快获取元素下标的位置,判断元素是否相等,从而得到时间效率的提升。 - 说一下HashMap插入元素和获取元素的逻辑?

答:参考插入元素方法和获取元素方法的篇章。

总结

这篇博客主要是写了一些关于HashMap常用的方法和经常会被问到的一些问题,当然许多方面都没有做分析,像获取树上的元素,怎么往红黑树中插入元素,以及树化等等,因为树相关的操作又是一个非常大的内容,之后会找个时间详细的学习下树和树的相关操作,包括树的查找、插入、二叉树的查找和插入、红黑树的查找和插入等等,敬请期待……

最后,感谢各位的阅读,祝大家的技术节节高升……